Il potenziale nascosto dietro ogni sito Web

Questo è l’articolo che ho scritto per The Inbounder, pubblicato qualche ora fa in inglese. Qui vi propongo la versione originale in italiano.

In questo articolo vi parlo di una delle problematiche principali di ogni sito web, quella del potenziale sprecato in pagine che non portano traffico organico e di come con l’ingegno, idee e tanto lavoro sono riuscito a realizzare l’unico tool esistente in grado di capire cosa si aspettino gli utenti dalle vostre pagine web, gli argomenti su cui i vostri articoli sono carenti ed identificare le pagine web che stanno sprecando pesantemente il crawl budget che Google vi mette a disposizione.

Non è mia intenzione scrivere un articolo autopromozionale, voglio solo condividere con voi le riflessioni, le esigenze e la frustrazione nell’utilizzare tool inadeguati che mi ha portato a realizzarmene uno da solo che facesse esattamente quello di cui avevo bisogno. Uno strumento che non mostrasse solo dati ma che li elaborasse con algoritmi evoluti per trasformarli in informazioni preziose per poter agire concretamente ed ottenere risultati immediati.

Il potenziale nascosto dietro ogni sito web

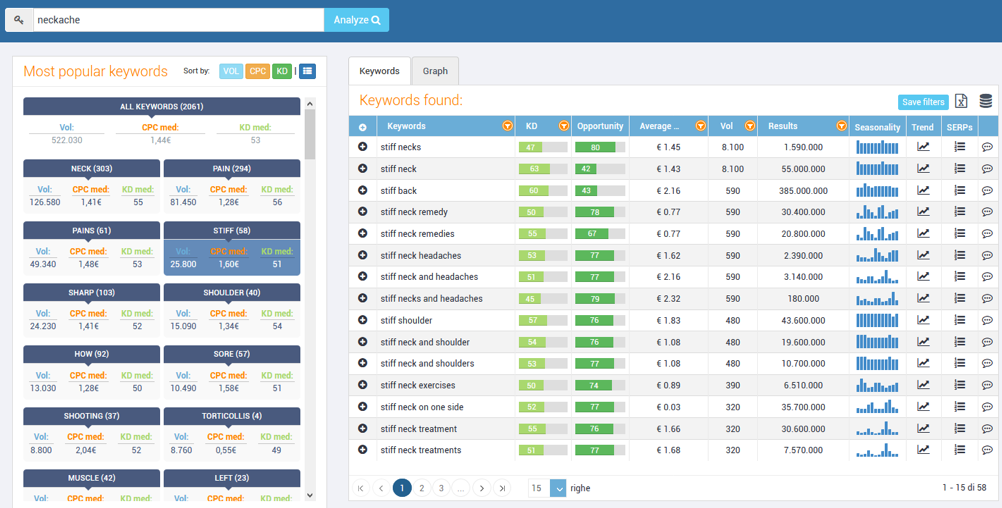

Ogni sito web, anche quello che potremmo considerare il peggiore, in quanto non ottiene traffico dai motori di ricerca, ha sempre un potenziale inespresso. Tante opportunità di incrementare il traffico che non possiamo cogliere a causa di problemi SEO tecnici o di contenuti non perfettamente a fuoco sulle esigenze degli utenti, come quello di cui vi mostro i dati nell’immagine seguente.

Nell’immagine, un sito web con decine di migliaia di keyword potenziali ma solo pochissime sono in top 10.

In dodici anni di lavoro come consulente SEO, nell’analisi preliminare, ho sempre dato enorme importanza allo studio del potenziale del sito web del nuovo cliente.

Spesso venivo contattato da aziende che non avevano lavorato neanche minimamente sui contenuti del proprio sito web e chiedevano a me di farlo per loro. Inutile dirvi che questa tipologia di cliente non l’ho mai voluto acquisire, è come andare dal nutrizionista e chiedere a lui di non mangiare al posto vostro.

Ma in altri casi, in realtà nella maggior parte, il cliente aveva già lavorato tanto producendo contenuti ricchi di informazioni, scritti con passione ma non centrando il punto più importante, quello che nasce da poche semplici domande:

“Per chi sto scrivendo questo contenuto?”.

“Come cercherei quello che sto scrivendo se fossi un utente di Google?”.

“Riuscirà Google a capire che sto rispondendo ad una domanda specifica dell’utente?”.

Chi produce contenuti, non sempre lo fa a scopi SEO, e tende a scriverli per passione, si sente appagato quando clicca il tasto “pubblica” del suo CMS consapevole di averci messo tutta la passione necessaria e tutta la sua conoscenza sull’argomento, ma poi dopo qualche giorno si rende conto di non aver avuto alcuna visita.

Questa è la tipologia di cliente che adoro, persone o aziende appassionate che si mettono in gioco ma a cui manca un ‘allenatore’ che non gli faccia sprecare il loro enorme potenziale.

Quando troviamo un cliente che lavora realmente al proprio sito ed abbiamo un buon potenziale di partenza, il risultato è assicurato al 100%.

Come analizzare il potenziale di un sito web

Per anni ho svolto questo lavoro manualmente scovando le keyword, dall’alto volume di ricerca (o che potessero convertire maggiormente in lead o vendite), per cui il sito web era in seconda o terza pagina delle SERP di Google. Inutile dirvi che il lavoro era estremamente lungo e poco fruttuoso, vi spiego perché:

- Partendo dalle keyword migliori dovevo individuare le URL su cui lavorare per ottenere traffico

- Dovevo decidere se valesse la pena o meno di modificare la pagina. Era probabile che l’URL scelto facesse già traffico su altre keyword e modificandone il contenuto avrei rischiato di perderlo.

- Prima di modificare un contenuto bisognava analizzare la SERP di Google per capire se il testo della nostra pagina era in focus con gli altri contenuti scelti da Google per la sua SERP. Questo serviva per capire se fosse il caso di riscriverlo completamente oppure fosse un buon candidato per dei semplici miglioramenti.

- Era anche necessario provare a capire per quali altre keyword importanti avevo chance di posizionare lo stesso contenuto semplicemente intervenendo sul testo, quindi andavano analizzate anche le pagine dei competitor per individuare le loro keyword rilevanti.

- Come tutti sappiamo, Google non risponde sempre con il risultato migliore, spesso è costretto a rispondere con “il meno peggio”. Questa informazione era per me fondamentale, sapere che me la sarei giocata con competitor scarsi sull’argomento era un vantaggio competitivo enorme.

Come potrete immaginare, dalla complessità e dalla quantità di informazioni necessarie per valutare ogni URL, avevo due strade. Abbandonare questa strada o realizzare uno strumento automatico che facesse tutto il lavoro da solo.

Da esigenze come questa mi è venuta l’idea di realizzare SEOZoom, una suite di strumenti SEO con un approccio completamente differente da qualsiasi altra suite esistente, volevo un tool “opportunity based” che mi aiutasse ad agire.

Vi riassumo solo qualche punto sull’approccio, lo scopo di questo post non è parlare di SEOZoom ma della filosofia utilizzata e che mi ha portato ad automatizzare tutto il lavoro.

Cosa vogliono gli utenti?

Avevo bisogno di qualcosa per capire tutti i modi in cui un utente potesse ricercare la stessa cosa su Google, per cui ho realizzato il primo algoritmo sull’identificazione del Search Intent mai rilasciato in uno strumento SEO. L’algoritmo fa reverse engineering delle SERP di Google riuscendo ad identificare tutte le keyword che possano essere ritenuti rilevanti per un topic specifico. Il primo passo verso lo studio del potenziale era stato fatto, potevo capire se le mie pagine web fossero abbastanza rilevanti su un topic e soprattutto se avessi approfondito abbastanza trattando altri argomenti importanti che i competitor avevano preso in considerazione.

L’approccio keyword/posizione classico dei Rank Tracker era inadeguato e di poco aiuto

Analizzare interi domini basandoci solo ed esclusivamente su griglie (excel style) con keyword, volume di ricerca, posizione, URL era improponibile, ci sarebbero voluti mesi per ogni sito web.

Mi domandavo come fosse possibile che qualsiasi tool esistente lavorasse solo in questo modo, era impossibile capire ogni pagina web quanto stesse rendendo, in termini di traffico organico, su TUTTE le sue keyword.

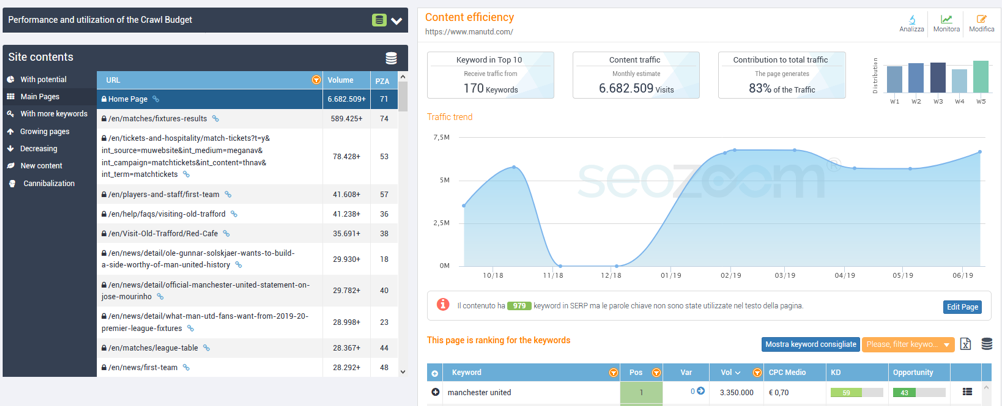

Per cui mi sono fatto venire una nuova idea, quella di creare il primo Rank Tracker che si basasse sulle URL e non sulle keyword, era qualcosa che non esisteva sul mercato delle SEO Suite. Finalmente potevo sapere in automatico, ogni pagina del sito per quante e quali keyword fosse posizionato, quali keyword gli portassero traffico e tutte le keyword potenziali su cui potevo lavorare, ma anche il rendimento della pagina nel tempo.

L’approccio a “pagine” di SEOZoom è stato di ispirazione anche per altri tool internazionali che dopo circa un anno dalla nostra release hanno adeguato i propri strumenti proponendo una soluzione simile in quanto dava sicuramente una visione differente sul rendimento di ogni pagina web.

Cosa vuole il SEO? La visione di insieme!

Sono sempre stato molto critico sul mio lavoro e, nonostante fossi soddisfatto del monitoraggio a pagine, mi sono reso conto che poteva essere molto più utile ad un copywriter che ad un SEO come me. Per il copy è comodo sapere su quale pagina intervenire per migliorarla, ma a me serviva qualcosa di più ricco di informazioni per agire globalmente su intere sezioni del sito.

Quello di cui avevo bisogno era di una “visione di insieme migliore”.

Avevo bisogno di suddividere le URL del mio sito web in gruppi organizzandoli in base al volume di traffico e realizzare degli algoritmi di analisi dei contenuti per poter ottenere quanto segue:

-

- Sapere quante e quali pagine sprecano crawl budget portando zero traffico al sito. In molti casi ho scoperto che il 90% del crawl budget veniva sprecato su pagine che non contribuivano al traffico del sito. I vari SEO spider ci mostrano i problemi tecnici delle nostre pagine ma nessuno spider riusciva a dirmi quali pagine servissero e quali invece erano completamente un peso per il sito.

- Capire quanto fosse stato stabile il posizionamento del mio sito web. In molti casi abbiamo solo una manciata di pagine che portano tutto il traffico e migliaia e migliaia di altre pagine che sprecano solo crawl budget. In questi casi il nostro traffico è a rischio, se crolla il posizionamento di una di quelle pagine potremmo perdere tutto, bisogna agire immediatamente per stabilizzare la nostra presenza in SERP rafforzando i contenuti deboli.

Nell’immagine precedente infatti si può notare che lo 0,06% delle pagine del sito producono da sole il 52% del traffico. In casi come questo sappiamo che il nostro traffico globale è a rischio. - Capire se gruppi di pagine competessero per le stesse keyword identificando potenziali cannibalizzazioni.

Quando curiamo un sito web da anni, è probabile che in più occasioni diverse ci troviamo a trattare nuovamente un argomento già trattato in precedenza.

In questi casi, a meno che non si abbia una gestione meticolosa della produzione dei contenuti e si provi a non sovrapporre le tematiche, si rischia di incorrere in problemi di cannibalizzazione, ossia di pagine web che competono per le stesse keyword.

In questi casi, una delle due pagine prende il sopravvento sull’altra che invece diventa solo un peso per Google che è comunque costretto a scansionarla sprecando crawl budget.

Passiamo all’azione!!!

Grazie agli strumenti che avevo creato potevo avere una visione di insieme delle pagine del sito in un istante, ma avevo bisogno di un ultimo tassello per creare la soluzione perfetta per le mie esigenze.

Per ogni pagina web problematica avevo bisogno di sapere esattamente come migliorarla per renderla più competitiva e colmare le carenze di contenuto rispetto ai competitor per cui ho realizzato dei nuovi algoritmi per automatizzare il lavoro che fino ad allora avrei fatto manualmente.

Vi spiego il processo da me realizzato per capire cosa fare su ogni pagina web:

-

-

- Dovevo analizzare il contenuto della mia pagina web per farne una valutazione qualitativa e quantitativa confrontandola con i contenuti proposti dai competitor in SERP.

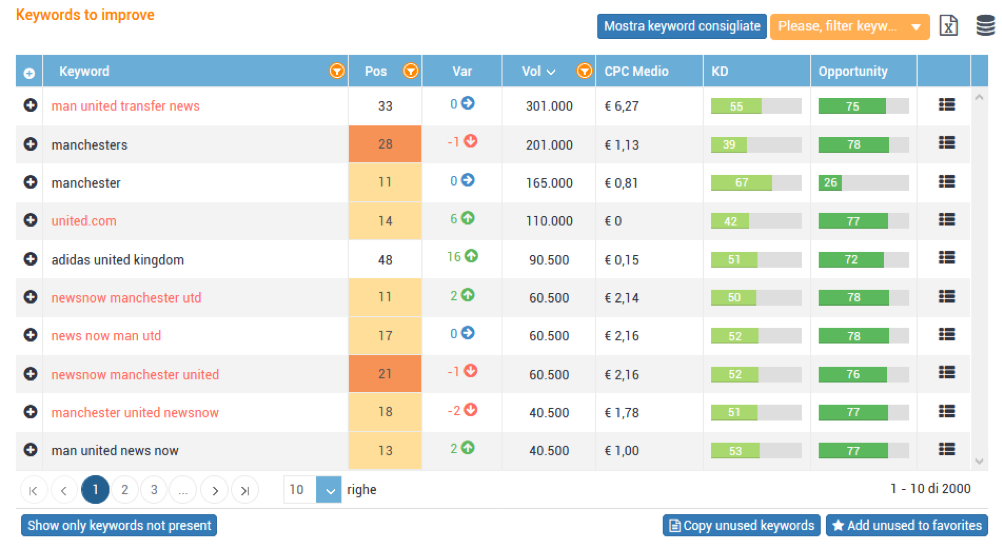

- Dovevo capire perché molte keyword vedevano la mia URL in seconda pagina in SERP oppure per niente posizionata, mentre le pagine dei competitor lo erano.

Per lo scopo ho realizzato un algoritmo per indentificare quello che ho battezzato come intent gap, il primo algoritmo in grado di identificare keyword potenziali e fortemente rilevanti per una URL facendo reverse engineering dei risultati di Google dei miei competitor.

-

Dovevo capire cosa avessero fatto i miei competitor sulle loro pagine. Avevo bisogno di sapere il loro traffico organico, le loro keyword, quali topic avevano trattato nella loro pagina, ma soprattutto cosa avessero fatto in più di me.

Elaborando i contenuti delle pagine dei competitor e le keyword per cui erano posizionati sono riuscito a capire cosa mancasse alla mia pagina, quali keyword mi ero perso, quali argomenti mi erano sfuggiti nel mio contenuto.

In rosso tutte le keyword per cui la mia pagina web era quasi in top10 senza che fosse mai utilizzata nel testo.

Concludiamo con l’arma segreta! L’assistente editoriale

Il mio ultimo desiderio era quello di percorrere tutto l’iter che vi ho descritto fino ad ora, cliccare un pulsante ed aprire un editor HTML che mi aiutasse a fare tutto quello che avevo individuato seguendomi passo passo e mostrandomi tutte le info delle pagine web con cui stavo andando a competere.

Delle pagine competitor volevo sapere:

- Quali topic avevano trattato

- Per quali keyword erano posizionati

- Come avevano utilizzato i tag TITLE

- Cosa avevano messo in H1, H2, H3

- Quali link interni avevano utilizzato

- Prendere ispirazione vedendo le frasi utilizzate per ogni argomento

- Avere un’idea immediata del volume di ricerca potenziale per cui stavo competendo con il mio articolo. Volevo anche che questo volume potenziale si aggiornasse in real time mentre modificavo il testo arricchendolo di argomenti e keyword.

Anche questa volta mi sono messo al lavoro e, con il mio team, ho realizzato il primo assistente editoriale circa tre anni fa, nato per esigenza personale ma attualmente utilizzato da 22.000 aziende in Italia.

Dopo tre anni circa, anche altri tool hanno seguito la nostra scia creando i loro strumenti per la scrittura.

Siamo arrivati alla conclusione, vi ho parlato un po’ del ‘behind the scenes’ della realizzazione della mia SEO Suite ma sono sicuro che tutto il percorso, i ragionamenti, l’evidenziare alcune esigenze fondamentali, possa esservi comunque di grande aiuto per avere un approccio differente alla SEO che spesso viene vista solo come risoluzione di problematiche meramente tecniche.

Un caso di studio dove ho applicato questa metodologia

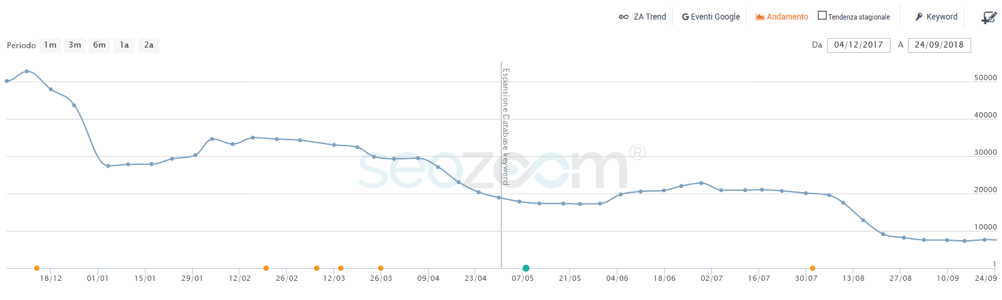

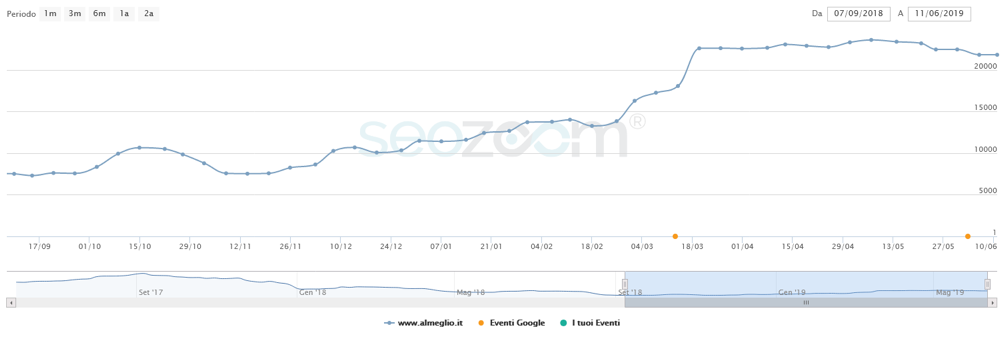

Il sito web almeglio.it continuava a perdere traffico nonostante la produzione di nuovi contenuti fosse costante, qualcosa non andava nella scelta degli articoli oppure le vecchie pagine stavano perdendo gradualmente traffico.

Il sito web impiegava il 90% del crawl budget per produrre zero traffico organico, la soluzione era intervenire sui contenuti più promettenti per poter aumentare il traffico con le pagine web che già avevamo a disposizione.

Grazie all’analisi effettuata sui contenuti ho capito su quali pagine fosse il caso di intervenire per colmare l’intent gap evidente.

Lavorando selettivamente sulle pagine con maggior potenziale, semplicemente modificando il testo rendendolo più in topic, come lo erano i competitor, sono riuscito a guadagnare tutto il traffico perduto nel tempo. Dopo il calo di traffico c’è stato un intervento sul contenuto riportandolo al traffico precedente.

Questo lavoro è stato svolto su circa 50 pagine ed ha richiesto circa una settimana di lavoro ma il risultato è stato decisamente soddisfacente. Le poche pagine modificate occupano circa il 3% del crawl budget ma, dopo l’intervento, producono circa il 46% del traffico globale del sito.

La SEO moderna è visione di insieme!

La SEO moderna è tante cose, tante discipline, ma come dico sempre è maggiormente visione di insieme!

Come Neo in Matrix, puoi sconfiggere il nemico solo quando i tuoi occhi riusciranno a vedere chiaramente il tuo sito web nella sua interezza, nella sua essenza.